Ihr möchtet mit eurem Team teilnehmen? Ab drei Personen profitiert ihr von unseren Gruppenrabatten! Direkt im Shop buchen!

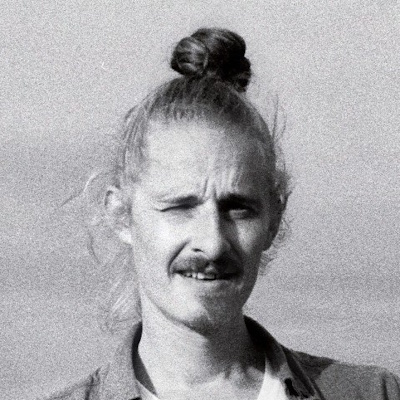

Oliver Frost hat verschiedene Rollen in der Datenwelt durchlaufen: Er war Business Analyst und Data Scientist bei ImmoScout24, und ist nun Cloud Architect bei dmTECH. Über die Jahre hat er Daten-Architekturen in den drei großen Hyperscalern (AWS, Azure, Google Cloud) gebaut. Zuletzt hat er diverse Datenstrecken von einem On-Premises-Hadoop-Cluster in die Google Cloud migriert.

Constantin Lehmann ist Machine-Learning-Engineer beim IT-Projekthaus inovex. Aktuell arbeitet er als externer Data-Engineer bei dm und hat für das Roboterprojekt von dm zahlreiche Datenstrecken konzipiert und implementiert. Gemeinsam mit Oliver hat er die Migration der Datenstrecken in die Google Cloud umgesetzt.